Climat

Changement climatique et réchauffement des océans

Analyse de l’impact du changement climatique sur les océans. Lien entre le changement climatique et le réchauffement des océans Plongez dans les profondeurs de l’océan …

Comprendre la modélisation climatique : techniques, prédictions et impacts

Introduction à la modélisation climatique Définition et objectifs de la modélisation climatique Vous avez déjà entendu parler de modélisation climatique ? Si ce n’est pas …

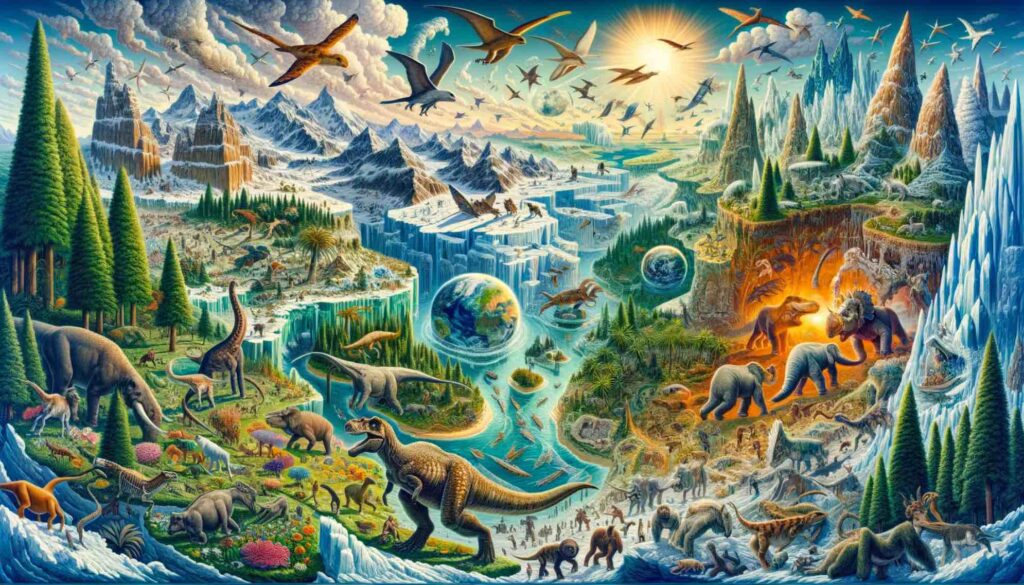

L’histoire du climat de la terre : une odyssée temporelle

Les fondements de l’histoire climatique terrestre Bonjour à tous les passionnés du climat et les curieux de l’histoire de notre planète ! Aujourd’hui, nous allons …

Energies Renouvelables

Bâtiments bas carbone

Les avantages de l’isolation par l’extérieur

Pour isoler au mieux votre maison ou bâtiment, réaliser des économies et faire du bien à la planète, plusieurs solutions existent. (Voir notre guide des …

Comprendre le changement climatique

Le changement climatique est l’un des plus grands défis de notre époque. Notre section dédiée vous aide à comprendre les causes, les impacts et les solutions possibles. Avec des explications claires et des données scientifiques, nous démystifions les aspects complexes du climat et vous fournissons les outils nécessaires pour appréhender ce phénomène global.

Explorer les énergies renouvelables

Les énergies renouvelables sont au cœur de la transition énergétique. Découvrez les dernières innovations en matière d’énergie solaire, éolienne, hydroélectrique et autres sources alternatives. Apprenez comment ces technologies transforment notre façon de produire et de consommer de l’énergie, tout en réduisant notre empreinte carbone.

Architecture durable et bâtiments bas carbone

L’architecture durable est essentielle pour réduire l’impact environnemental de nos habitats. Explorez des concepts innovants en matière de design écologique, de matériaux de construction durables et de pratiques de bâtiment bas carbone. Nous vous guidons à travers les tendances et les meilleures pratiques pour des constructions respectueuses de l’environnement.

Révolutionner le transport pour un avenir durable

Le secteur des transports est un acteur clé dans la transition vers un avenir plus durable. Dans cette section, nous explorons les dernières innovations en matière de transport écologique. Découvrez comment les véhicules électriques, les solutions de mobilité partagée, les transports en commun éco-efficaces et les avancées dans les carburants alternatifs contribuent à réduire l’empreinte carbone du secteur.

Nous abordons également les tendances émergentes comme l’hyperloop, les drones de livraison écologiques et les innovations dans les secteur du transport aérien et du transport maritime pour minimiser les émissions. Cette partie du site est dédiée à vous informer sur la façon dont la technologie et l’ingéniosité transforment notre façon de voyager et de commercer, de manière à la fois respectueuse de l’environnement et efficace.

Innovation et technologies écologiques

Le progrès technologique joue un rôle crucial dans la protection de notre planète. Notre section sur les innovations écologiques présente les dernières avancées en matière de technologies propres et durables. Découvrez comment ces innovations peuvent aider à résoudre les défis environnementaux et favoriser un développement durable.

Agir pour l’environnement

Chacun de nous peut contribuer à la lutte contre le changement climatique. Nous vous proposons des conseils pratiques et des actions concrètes pour réduire votre empreinte carbone, participer à des initiatives écologiques et adopter un mode de vie plus durable.

Energieclimat.net est plus qu’un site d’information – c’est une communauté de personnes engagées et conscientes, œuvrant ensemble pour un avenir plus vert. Rejoignez-nous dans cette mission essentielle. Ensemble, nous pouvons faire une différence significative pour notre planète.